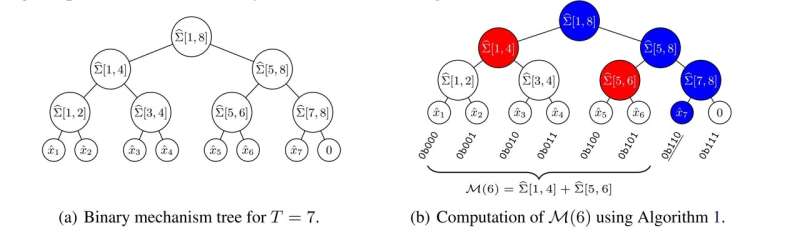

درختان دودویی برای دنباله ای به طول T = 7. در شکل 1(b) هر برگ با bin(t-1) برچسب گذاری شده است، و نشان می دهد که چگونه جمع پیشوند تا t = 6 را می توان از bin

محققان دانشگاه کپنهاگ نرمافزاری توسعه دادهاند که میتواند دادههای حساسی مانند دادههای مورد استفاده برای یادگیری ماشین در برنامههای مراقبتهای بهداشتی را پنهان کند. این روش از حریم خصوصی محافظت می کند در حالی که مجموعه داده ها را برای توسعه درمان های بهتر در دسترس قرار می دهد.

یک عنصر کلیدی در مراقبت های بهداشتی مدرن، جمع آوری و تجزیه و تحلیل داده ها برای گروه بزرگی از بیماران برای کشف الگوها است. کدام بیماران از یک درمان معین سود می برند؟ و کدام بیماران احتمال دارد عوارض جانبی را تجربه کنند؟

چنین داده هایی باید محافظت شوند، در غیر این صورت حریم خصوصی افراد شکسته می شود. علاوه بر این، نقض به اعتماد عمومی آسیب می رساند و منجر به رضایت افراد کمتری برای مشارکت می شود. محققان دپارتمان علوم کامپیوتر دانشگاه کپنهاگ راه حلی هوشمندانه یافته اند.

ما موارد متعددی را دیدهایم که در آن دادهها ناشناس بوده و سپس در اختیار عموم قرار گرفتهاند، و با این حال محققان موفق به بازیابی هویت شرکتکنندگان شدهاند. از آنجایی که بسیاری از منابع اطلاعاتی دیگر در مالکیت عمومی وجود دارد، دشمنی با یک کامپیوتر خوب اغلب میشود قادر به کسر هویت حتی بدون نام و کد شهروندی است.”

دکتر Ph.D می گوید: «ما یک روش عملی و اقتصادی برای محافظت از مجموعه داده ها در هنگام استفاده برای آموزش مدل های یادگیری ماشین ایجاد کرده ایم. دانش آموز جوئل دانیل اندرسون

میزان علاقه به الگوریتم جدید را می توان با این واقعیت نشان داد که جوئل برای ارائه یک گفتگوی فناوری گوگل در مورد آن دعوت شد. همچنین، او اخیراً در کنفرانس NeurIPS در مورد یادگیری ماشین سخنرانی کرد.

به طور عمدی خروجی شما را آلوده می کند

ایده اصلی این است که مجموعه داده خود را با افزودن “نویز” به هر خروجی حاصل از آن پنهان کنید. برخلاف رمزگذاری که نویز اضافه می شود و بعداً حذف می شود، در این حالت نویز باقی می ماند. هنگامی که نویز اضافه می شود، نمی توان آن را از خروجی “واقعی” تشخیص داد.

بدیهی است که صاحب یک مجموعه داده نباید از نویز کردن خروجی های حاصل از آن خوشحال باشد.

جوئل دانیل اندرسون میگوید: «کاربرد پایینتر مجموعه داده، هزینهای است که برای تضمین حریم خصوصی شرکتکنندگان میپردازید.

او خاطرنشان می کند که وظیفه کلیدی اضافه کردن مقدار نویز کافی برای پنهان کردن نقاط داده اصلی است، اما همچنان ارزش بنیادی مجموعه داده را حفظ می کند:

“اگر خروجی به اندازه کافی نویز داشته باشد، استنباط مقدار یک نقطه داده در ورودی غیرممکن می شود، حتی اگر هر نقطه داده دیگری را بشناسید. با نویز کردن خروجی، ما در واقع ریل های ایمنی را به تعامل بین اضافه می کنیم. تحلیلگر و مجموعه داده.”

“تحلیلگران هرگز به داده های خام دسترسی ندارند، آنها فقط سوالاتی در مورد آن می پرسند و پاسخ های پر سر و صدا دریافت می کنند. بنابراین، آنها هرگز هیچ اطلاعاتی در مورد افراد در مجموعه داده نمی آموزند. این امر از درز اطلاعات، سهوی یا غیر عمدی، ناشی از تجزیه و تحلیل داده ها محافظت می کند. “

حریم خصوصی با یک برچسب قیمت همراه است

هیچ مبادله بهینه جهانی وجود ندارد. جوئل دانیل اندرسون میگوید، “شما میتوانید مبادلهای را انتخاب کنید که متناسب با هدف شما باشد. برای برنامههایی که حفظ حریم خصوصی بسیار مهم است – به عنوان مثال، دادههای مراقبتهای بهداشتی – میتوانید سطح بسیار بالایی از حریم خصوصی را انتخاب کنید. این به معنای اضافه کردن مقدار زیادی از سر و صدا.”

“به ویژه، این گاهی اوقات به این معنی است که شما باید تعداد نقاط داده خود را افزایش دهید – به عنوان مثال، افراد بیشتری را در نظرسنجی خود بگنجانید – تا ارزش مجموعه داده خود را حفظ کنید. در برنامه هایی که حفظ حریم خصوصی اهمیت کمتری دارد، می توانید یک مورد را انتخاب کنید. به این ترتیب، کاربرد مجموعه داده خود را حفظ خواهید کرد و هزینه های مربوط به تامین حریم خصوصی را کاهش خواهید داد.”

او اضافه میکند که کاهش هزینهها دقیقاً اصلیترین استدلال پشت روش توسعهیافته توسط گروه تحقیقاتی است. “مهم این است که برای دستیابی به سطح مشخصی از حریم خصوصی، چه مقدار نویز باید اضافه کنید، و اینجاست که مکانیسم صاف ما نسبت به روش های موجود بهبود می بخشد. ما موفق می شویم نویز کمتری اضافه کنیم و این کار را با منابع محاسباتی کمتر انجام می دهیم. به طور خلاصه، ما کاهش هزینه های مرتبط با تامین حریم خصوصی.”

علاقه از صنعت

یادگیری ماشینی شامل مجموعه داده های بزرگی است. به عنوان مثال، در بسیاری از رشته های مراقبت های بهداشتی، یک کامپیوتر می تواند الگوهایی را پیدا کند که متخصصان انسانی نمی توانند آن ها را ببینند. همه اینها با آموزش رایانه بر روی مجموعه داده با موارد واقعی بیمار شروع می شود. چنین مجموعه های آموزشی باید محافظت شوند.

“بسیاری از رشته ها به طور فزاینده ای به یادگیری ماشین وابسته هستند. علاوه بر این، ما شاهد گسترش یادگیری ماشینی فراتر از حرفه ای ها مانند پزشکان به برنامه های خصوصی مختلف هستیم. این پیشرفت ها فرصت های جدیدی را ایجاد می کند، اما همچنین نیاز به محافظت از حریم خصوصی شرکت کنندگانی را که این سیستم را ارائه می دهند افزایش می دهد. دادههای اصلی، “جوئل دانیل اندرسون توضیح میدهد که علاقه به نرمافزار جدید گروهها صرفا علمی نیست.

علاوه بر بخش مراقبتهای بهداشتی بهعلاوه گوگل و سایر شرکتهای فناوری بزرگ، صنایعی مانند مشاوران، شرکتهای حسابرسی و شرکتهای حقوقی باید بتوانند از حریم خصوصی مشتریان و شرکتکنندگان در نظرسنجیها محافظت کنند.»

مقررات عمومی فراخوانده شده است

این زمینه به عنوان حریم خصوصی دیفرانسیل شناخته می شود. این اصطلاح از تضمین حریم خصوصی برای مجموعه دادههایی که در یک نقطه داده متفاوت هستند مشتق شده است: خروجی براساس دو مجموعه داده که فقط در یک نقطه داده متفاوت هستند مشابه به نظر میرسد. این امر باعث می شود که تحلیلگر نتواند یک نقطه داده واحد را شناسایی کند.

این گروه تحقیقاتی از نهادهای عمومی حمایت می کند که علاقه بیشتری به این زمینه داشته باشند.

“از آنجایی که حفاظت از حریم خصوصی بهتر با قیمت بالاتر به دلیل از دست دادن ابزار مفید همراه است، به راحتی به رقابتی برای فعالان بازار تبدیل می شود. مقررات باید وجود داشته باشد و بیان کند که یک برنامه حساس خاص به حداقل سطح خاصی از حریم خصوصی نیاز دارد. این زیبایی واقعی حریم خصوصی دیفرانسیل است.”

جوئل دانیل اندرسون میگوید: «شما میتوانید سطح حریم خصوصی مورد نیاز خود را انتخاب کنید، و چارچوب دقیقاً به شما میگوید که برای رسیدن به آن سطح به چه میزان سر و صدایی نیاز دارید». او امیدوار است که حریم خصوصی متمایز ممکن است به تسهیل استفاده از یادگیری ماشین کمک کند.

“اگر دوباره نظرسنجیهای پزشکی را به عنوان مثال در نظر بگیریم، آنها از بیماران میخواهند که رضایت خود را برای شرکت در آن اعلام کنند. به دلایل مختلف، شما همیشه برخی از بیماران را از دادن رضایت امتناع میکنند یا فراموش میکنند که منجر به کاهش ارزش مجموعه داده میشود. از آنجایی که می توان تضمین احتمالی قوی مبنی بر عدم نقض حریم خصوصی شرکت کنندگان ارائه داد، عدم نیاز به رضایت و دستیابی به مشارکت 100 درصدی به نفع تحقیقات پزشکی می تواند از نظر اخلاقی قابل دفاع باشد.

“اگر افزایش مشارکت به اندازه کافی بزرگ باشد، از دست دادن سودمندی ناشی از ارائه حریم خصوصی می تواند با افزایش سودمندی از داده های اضافی جبران شود. به این ترتیب، حریم خصوصی متفاوت می تواند به یک برد برد برای جامعه تبدیل شود.”

کار است منتشر شده بر روی arXiv سرور پیش چاپ

اطلاعات بیشتر:

جوئل دانیل اندرسون و همکاران، مکانیزم دوتایی صاف برای مشاهده مستمر خصوصی کارآمد، arXiv (2023). DOI: 10.48550/arxiv.2306.09666

نقل قول: دانشمندان کامپیوتر داده های پر سر و صدا می کنند: آیا می تواند درمان ها را در مراقبت های بهداشتی بهبود بخشد؟ (2024، 16 ژانویه) در 16 ژانویه 2024 از

این برگه یا سند یا نوشته تحت پوشش قانون کپی رایت است. به غیر از هرگونه معامله منصفانه به منظور مطالعه یا تحقیق خصوصی، هیچ بخشی بدون اجازه کتبی قابل تکثیر نیست. محتوای مذکور فقط به هدف اطلاع رسانی ایجاد شده است.