علاوه بر Myllyaho، مطالعه توسط Mikko Raatikainen، Tomi Männistö، Jukka K. Nurminen و Tommi Mikkonen انجام شد. این نشریه بر اساس مصاحبههای کارشناسان تنظیم شده است.

نقل قول: مطالعه: مدل های یادگیری ماشین را نمی توان با اطمینان مطلق اعتماد کرد (2023، 18 آوریل) بازیابی شده در 18 آوریل 2023 از

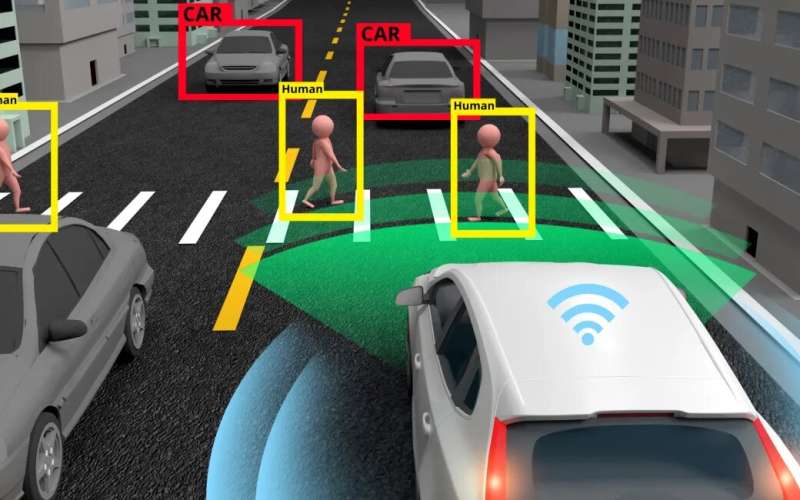

اگر مدلهای یادگیری ماشینی حاوی دادههای شکسته باشند، مشکل میتواند به سیستمهایی که در اجرای آنها از مدلها استفاده شدهاند نیز گسترش یابد. همچنین لازم است مشخص شود که کدام مکانیسم ها برای تصحیح خطاها مناسب هستند.

Myllyaho میگوید: «ایده اساسی این مطالعه این است که اگر سیستمهای حیاتی را در اختیار هوش مصنوعی و الگوریتمها قرار دهید، باید یاد بگیرید که برای شکست آنها آماده شوید.

Myllyaho میگوید: «معماران نرمافزار درباره نقصها و نادرستیهای موجود در مدلهای یادگیری ماشین و اطراف آن مصاحبه شدند.

این برگه یا سند یا نوشته تحت پوشش قانون کپی رایت است. به غیر از هرگونه معامله منصفانه به منظور مطالعه یا تحقیق خصوصی، هیچ بخشی بدون اجازه کتبی قابل تکثیر نیست. محتوای مذکور فقط به هدف اطلاع رسانی ایجاد شده است.