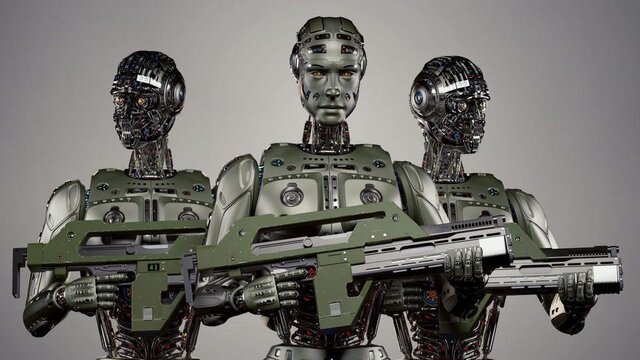

سلاح های خودکار کشنده(LAW) چه هستند؟

در طرف دیگر، کشورهایی هستند که میگویند یک کشور باید از خود دفاع کند که این امر به معنای همگام شدن با فناوری اطلاعات دیگر است. هوش مصنوعی میتواند در شطرنج و پوکر از انسان پیشی بگیرد. در دنیای واقعی نیز از انسانها بهتر عمل میکند. به عنوان مثال مایکروسافت ادعا می کند که نرم افزار تشخیص گفتار آن دارای یک درصد خطا است و این در حالی است که خطای انسانی حدود شش درصد است. بنابراین تعجب آور نیست که ارتشها به آرامی کنترل الگوریتمها را به دست بگیرند. اما چگونه از افزودن رباتهای قاتل به فهرست چیزهایی که آرزوی میکردیم هرگز تصمیم نگرفتیم؟ اول از همه: دشمنت را بشناس.

این مجوز، به افسران پلیس اجازه میدهد تا بمبی را به بازوی مکانیکی ربات ببندند، آن را در مجاورت قانونشکن مورد نظر قرار دهند و دکمههای را بزنند تا منفجر شوند. این راهبرد شش سال پیش در دالاس آغاز شد. زمانی که پلیس چند ساعت با یک تکتیرانداز در کشمکش گرفتار شد که پنج مامور را کشتند. زمانی که آنها یک ربات حامل مواد منفجره را مستقر کردند، کشمکش پایان یافتند. این اقدام در آن زمان، در مورد استفاده از نیروی مرگبار ربات شگفتزده کرد.

حضور رباتهای قاتل در پلیس آمریکا

وزارت دفاع ایالات متحده دولت سیستم تسلیحاتی خودکار را اینگونه تعریف می کند: سیستم تسلیحاتی که پس از فعال شدن، میتواند امنیت بیشتری را بدون استفاده از اپراتور انسان انتخاب کرده و هدف قرار دهد. بسیاری از سیستم های رزمی در حال حاضر با این شرایط مطابقت دارند. رایانههای روی پهپادها و موشکهای الگوریتمهایی هستند که میتوانند انسان را شناسایی کنند و با دقت بسیار بیشتری نسبت به آنها به سمت آنها شلیک کنند. سلاحهای مجهز به هوش مصنوعی نیز وجود دارند که برای حمله به مردم طراحی شدهاند، از ربات نگهبان گرفته شده تا پهپادهای کامیکازه سرگردان که در جنگ از مردم استفاده میکنند. پهپاد انتحاری، پهپاد کامیکازه یا مهمات پرزن (Loitering munition) نوعی سامانه تسلیحاتی است که در آن مهم برای مدتی در محدودهای هدف را جستجو میکنند (اصطلاحا «پرسهزنی» میکنند) و پس از آن هدفی را به آن حمله میکنند.

این قلمرو از نظر قانونی جدید است. در پیشنویسهای قبلی که برای بازنگری دولت ارائه میشد، یکی از بندهای قوانین بیان میکرد که رباتها نباید از ابزار زور علیه کسی که بروند استفاده میکنند، استفاده کنند. با وجود این، پلیس در ماه سپتامبر این بند را حذف کرد و در حقیقت این قانون را پا گذاشت که ربات زیر به انسان آسیب ندهد.

مجریان قانون در سانفرانسیسکو طی سالهای گذشته، انبار مهمات رو به رشدی را توسعه داده اند. طبق گزارش ها، یکی از برنامه های فدرال آن با نارنجی، سرنیزه، خودروهای زرهی و لباس های استار آمیخته است. این شهر ناوگان آن متشکل از ۱۲ ربات است که بخشی از آنها با دلارهای فدرال خریداری شده و مازاد نظامی را به دست آورد. یکی از مدلهای آن موسوم به “QinetiQ TALON”، یک ربات جنگی مشهور است. “اداره پلیس سانفرانسیسکو”(SFPD) در ماه سپتامبر سال گذشته، حق نظارت بر خروجیهای ویدئویی زنده را که از دوربینهای خصوصی متعلق به کارکنان و غیرنظامیان به دست میآیند، دریافت میکند که به ایجاد ترس از یک دولت نظارتی روی رشد میشود. برخی از کاربران توییتر این واقعیت را هدف قرار می دهند که پلیس و رسانه ها به طور یکسان سعی می کنند تا این موضوع را ثابت کنند که ربات های پلیس حامل مسلسل یا موشک هسته ها را می سازند، بلکه فقط منفجره متوسط را حمل می کنند.

پیشبینی این سیاست توسط هیئت نظارت میشود اما هنوز در جلسه بعدی باید اولین رای کسب کند و از تبدیل شدن به قانون توسط شهردار تأیید شود. طبق گزارشها، اداره پلیس سانفرانسیسکو گفته است که رباتها را به سلاحهای گرم مجهز نمیکند اما این مجوز به طور مشخص مانع از امکانی نمیشود. این کار پیش از انتقاد سایر مقامات شهر، ناظران حقوق دیجیتال و بسیاری از کاربران اینترنتی قرار گرفته بودند. نامهای که از «دفتر دفاع عمومی سانفرانسیسکو» ارسال شد، این سیاست را غیرانسانیها و نظامیان نامید. دیگران استدلال کردند که حامیان آن، ترس را به طور پنهانی به عنوان تاکتیکی برای افزایش قدرت پلیس به کار میبرند. در مقابل، دستیار رئیس پلیس در جلسه هیئت مدیره شهر، به ماجرای تیراندازی در یک جشنواره موسیقی سال ۲۰۱۷ در لاسوگاس استناد کرد و مدعی شد که یک ربات میتواند این مصیبت را کمتر کند.

آینده ما

در هر حال، مشکل رباتهای قاتل موضوع نیست. این موضوع سالهاست که نگرانان را نگران کرده است. شرکت “بوستون داینامیکس”(Boston Dynamics) که سگ رباتیک معروفی به نام “اسپات”(Spot) را طراحی کرده است، پس از آن که به اداره پلیس نیویورک اجاره داده بود، طی یک حمله به خانهای در منطقه برانکس نیویورک به کار رفت، مورد انتقاد قرار گرفت. ماهها بعد، همکاری اسپات با پلیس نیویورک لغو شد. بوستون داینامیکس در حال حاضر یکی از معدود سازندگان ربات به شماره میرود که صریحا با مسلح کردن ساختههای خود مخالف است. این شرکت در ماه اکتبر، نامه سرگشادهای را امضا کرد و در آن اظهار داشت که این کار، آسیب و مسائل اخلاقی جدی را به همراه دارد. به عنوان مثال، اگر یک ربات به طور تصادفی کسی را بکشد، چه کسی مقصر است؟

با انتشار خبرهای مبنی بر استفاده از رباتها در ماموریتهای پلیس آمریکا و مسلح کردن آنها، واکنشهای منفی به این موضوع شدت گرفتهاند. اخیراً مقامات شهر سانفرانسیسکو به پلیس این شهر این اختیار را دارند که از رباتهای قابل کنترل از راه دور استفاده کند. این رباتها، ماشینهایی به اندازهها هستند که از چرخدندهها و اهرمهای تعبیهشده روی چرخها ساختهشدهاند و در حال حاضر میتوانم آنها را آموزش دهند.

داستانهای علمی-تخیلی به علمی تبدیل میشوند

دانشمندان معتقدند که با روی کار آمدن فناوری رباتیک به عنوان ابزاری جهت کشتن انسانها چه به صورت خودکار و یا کنترل از راه دور، تصمیم گیری برای کشتن محیط بیگناه بسیار آسانتر از شرایط واقعی خواهد شد.

غیرنظامیان در بسیاری از مردم (مانند ویتنام افغانستان و ایمن) به دلیل شیوههایی که ابرقدرتهای جهانی در ساخت و استفاده از سلاحهای پیشرفته به طور فزایندهای استفاده میکنند، آسیب دیدهاند. بسیاری از استدلالهای مردم میسازند که بیشتر ضرر کردهاند تا سودهایی که نمونهای از آن حمله به روسیه در اوایل سال ۲۰۲۲ است.

نولان اظهار کرد، این رباتهای کشنده میشوند، زیرا میتوانند باعث بروز قتلهای غیرقانونی شوند. وی افزود، ممکن است با استفاده از این رباتها حوادث بزرگ و وحشتناکی رخ دهد زیرا آنها رفتارهای غیر منتظرهای از خود نشان میدهند. به همین دلیل هر سیستم تسلیحاتی پیشرفته باید تحت کنترل دقیق انسان قرار گیرد. در غیر این صورت باید از آن استفاده شود زیرا بسیار خطرناک بود.

برنامههای کاربردی همچنین پیشتر گفتهاند که جایگزینی هوش مصنوعی در هدفگیری و تصمیمگیری به شلیک به جای منطق انسان یک تصمیم کاملاً خطرناک و غیرعاقلانه است، چرا که در این حالت یک ربات تصمیم میگیرد که به یک هدف انسانی بدون در نظر گرفتن منطقی و مهم جان میپردازد. انسان شلیک کند.

چرا ما به سلاح های خودکار نیاز داریم؟

برای آخرینهای آمریکایی که فیلمهای هالیوودی بسیار را در مورد هوش مصنوعی ساختهاند، این حقیقتی تاریک است. از آنجایی که یکی از رباتهای چهارپایه شرکت گوست روباتیکس (Ghost Robotics) است که محصولاتی را برای ارتش آمریکا عرضه میکند، در حال حاضر با حمل سلاح در کنفرانسی در واشنگتن نمایش داده میشود، این شرکت در اکتبر گذشته به تیتر خبرها تبدیل میشود. و واکنشهایی را دریافت کرد.

انتهای پیام